Abstract

Questa ricerca documenta l’evoluzione architetturale e funzionale di un Gemello Digitale finanziario basato su un’architettura RAG (Retrieval-Augmented Generation) ibrida. Il percorso evolutivo abbraccia quattro stadi distinti: dall’Analista Aumentato all’Orchestratore Quant-Aumentato, dimostrando come la fusione di paradigmi computazionali diversi possa creare agenti decisionali di potenza e robustezza senza precedenti. L’analisi presenta una cronologia simulata che illustra la progressiva crescita delle capacità del sistema, dalla risposta passiva alle interrogazioni umane all’esecuzione autonoma di strategie di investimento guidate da ottimizzazione quantistica.

Parole chiave: Gemello Digitale, RAG Ibrido, Intelligenza Artificiale Finanziaria, Quantum Computing, Automazione Governata

1. Introduzione

L’evoluzione dei sistemi di Intelligenza Artificiale nel settore finanziario ha raggiunto un punto di svolta critico. La questione centrale nell’architettura dei moderni sistemi AI tocca il cuore del compromesso tra semplicità, controllo e performance. Mentre i sistemi tradizionali si limitano a fornire analisi retrospettive o supporto decisionale passivo, emerge la necessità di agenti capaci di evolversi da semplici strumenti di consultazione a partner strategici autonomi.

Questo studio presenta l’evoluzione di un Gemello Digitale finanziario attraverso quattro stadi evolutivi distinti, ognuno caratterizzato da capacità crescenti di autonomia e sofisticazione decisionale. L’architettura proposta si basa su un approccio RAG ibrido che combina le forze di modelli di embedding specializzati (TensorFlow) per la conoscenza profonda e stabile, con l’agilità dei modelli di embedding via API per dati dinamici.

2. Fondamenti Teorici: L’Architettura RAG Ibrida

2.1 Il Compromesso Strategico nella Vettorializzazione

La scelta dell’approccio di vettorializzazione rappresenta un compromesso strategico fondamentale. Da un lato, l’utilizzo di provider LLM unificati (come OpenAI) offre semplicità estrema e coerenza semantica perfetta. Dall’altro, l’adozione di modelli dedicati (TensorFlow) garantisce controllo totale, specializzazione del dominio e stabilità a lungo termine.

Approccio 1: Vettorializzazione via Provider LLM

- Vantaggi: Semplicità implementativa, coerenza semantica nativa, performance out-of-the-box

- Svantaggi: Costi elevati a scala, mancanza di controllo, rischio di obsolescenza forzata

Approccio 2: Vettorializzazione con Modelli Dedicati

- Vantaggi: Controllo totale, personalizzazione tramite fine-tuning, efficienza economica, indipendenza tecnologica

- Svantaggi: Complessità MLOps, potenziale gap semantico con LLM generativi

2.2 La Soluzione Ibrida: Criteri Decisionali

L’architettura proposta adotta una strategia di vettorializzazione differenziata basata su criteri specifici:

- Natura e Stabilità del Dato

- Dati statici e di dominio → Modelli dedicati (TensorFlow)

- Dati dinamici e volatili → API LLM

- Sensibilità e Privacy

- Dati sensibili/proprietari → Modelli in-house

- Dati pubblici → Approccio flessibile

- Tipo di Compito

- Ricerca semantica profonda → Modelli specializzati

- Query conversazionali → Provider LLM

3. Metodologia: La Cronologia Evolutiva

La ricerca adotta un approccio di simulazione cronologica per documentare l’evoluzione progressiva delle capacità del sistema. La metodologia simula quattro giorni consecutivi (23-26 giugno 2025), ognuno caratterizzato da un livello crescente di autonomia e sofisticazione.

4. Risultati: I Quattro Stadi Evolutivi

4.1 Giorno 1 (23 Giugno): L’Analista Aumentato

Scenario: Valeria, analista finanziaria senior, pone una domanda complessa che richiede la correlazione tra dati strategici a lungo termine e informazioni di mercato real-time.

Query: “Analizza la performance di MegaCorp nel contesto del report annuale e della chiusura odierna”

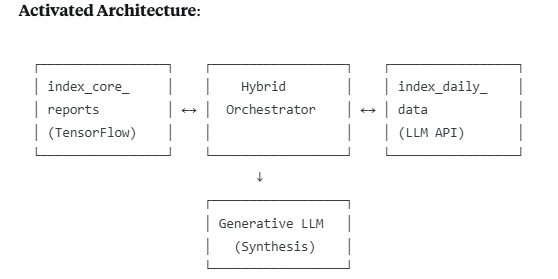

Architettura Attivata:

Processo:

- L’Orchestratore interroga simultaneamente

index_core_reports(vettorializzato con TensorFlow per stabilità) eindex_daily_data(vettorializzato con API LLM per agilità) - Recupera testo pertinente da entrambe le fonti

- Costruisce un prompt contestualizzato per la sintesi finale

Capacità Dimostrate: Analisi passiva (Q&A), fusione di dati eterogenei, supporto decisionale umano.

4.2 Giorno 2 (24 Giugno): Il Partner Proattivo

Scenario: Valeria approfondisce il rischio competitivo tra MegaCorp e FutureTech.

Query: “Valuta il rischio competitivo di MegaCorp rispetto a FutureTech considerando le roadmap di prodotto”

Evoluzione Architettuale: Il sistema non si limita a rispondere, ma attiva un monitoraggio proattivo.

Processo Bimodale:

Fase 1 (Reattiva):

- Analisi comparativa delle roadmap aziendali

- Identificazione della minaccia principale: batteria “Odyssey” di FutureTech

Fase 2 (Proattiva):

- Trigger Autonomo: La query di Valeria attiva un task di monitoraggio real-time

- Rilevazione: Sistema identifica notizia critica riguardante FutureTech

- Raccomandazione: Genera output JSON strutturato per validazione umana

json{

"evento_rilevato": "Ritardo lancio Odyssey - 6 mesi",

"impatto_stimato": "Riduzione significativa minaccia competitiva",

"raccomandazione": "MONITORARE per opportunità tattiche",

"confidence_level": "Alto"

}

Capacità Dimostrate: Comprensione contestuale, monitoraggio proattivo, generazione di insight azionabili, collaborazione human-in-the-loop.

4.3 Giorno 3 (25 Giugno): L’Agente Autonomo con Mandato di Rischio

Scenario: Ore 17:46 CEST – Nessun input umano. Flash news: “CEO di FutureTech si dimette con effetto immediato per divergenze strategiche.”

Evoluzione Critica: Prima esecuzione completamente autonoma.

Mandato Pre-Configurato:

json{

"ticker": "MCORP",

"max_trade_size_abs": 1000,

"max_trade_impact_pct": 0.5,

"confidence_threshold": "Alto",

"status": "ATTIVO"

}

Processo Decisionale Autonomo:

- Analisi Multi-Sorgente:

- Fondamentali (TensorFlow): Conferma solidità MCORP

- Mercato (API LLM): Prezzo stabile pre-notizia

- Live News: Evento destabilizzante per concorrente

- Sintesi Decisionale:

json{

"ticker": "MCORP",

"decisione": "ACQUISTARE",

"motivazione": "Dimissioni CEO concorrente elimina principale minaccia medio termine",

"livello_di_confidenza": "Alto",

"quantita": 700,

"verifica_mandato": {

"rientra_nei_limiti": true,

"impatto_portafoglio": "0.45%"

}

}

- Esecuzione: Sistema inoltra autonomamente ordine via API broker

Capacità Dimostrate: Automazione end-to-end, esecuzione autonoma, gestione del rischio basata su regole (automazione governata).

4.4 Giorno 4 (26 Giugno): L’Orchestratore Quant-Aumentato

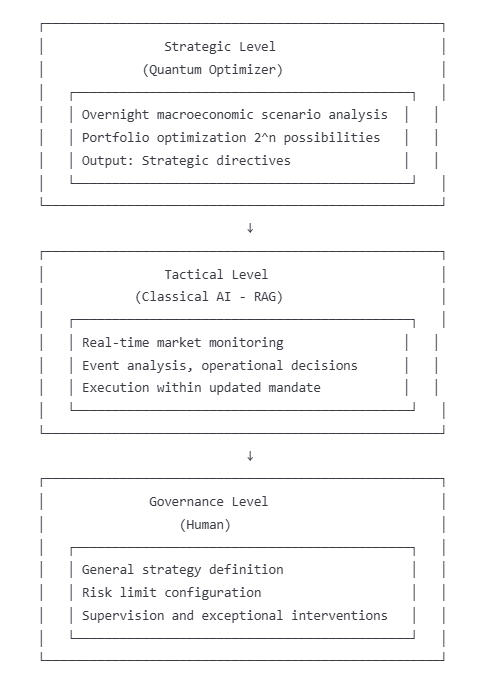

Innovazione Architettuale: Introduzione del livello quantistico per analisi strategica notturna.

Architettura a Tre Livelli:

Processo Quantistico Notturno:

Input: Posizioni portafoglio, matrici correlazione, scenari macroeconomici identificati dall’LLM

Compito (Quantum Annealing):

“Dati questi scenari e le loro probabilità stimate, esplora tutte le possibili traiettorie future e identifica l’allocazione di portafoglio che offre il miglior profilo rischio/rendimento (Sharpe Ratio). Indica quali tendenze settoriali sono strategicamente più robuste.”

Output Quantistico:

json{

"analisi_quantistica_id": "QA_20250626_0200",

"tendenza_confermata": "Sovrappesare semiconduttori avanzati per veicoli autonomi",

"motivazione_quantistica": "Analisi su 2^512 possibili percorsi mostra massima robustezza contro scenari inflazione/rallentamento",

"aggiornamento_mandato_suggerito": {

"ticker": "MCORP",

"nuovo_risk_appetite_factor": 1.5,

"note": "MCORP identificato come veicolo ottimale per implementare tendenza"

}

}

Azione Tattica Quant-Aumentata:

Quando si verifica lo stesso evento del giorno precedente (dimissioni CEO FutureTech), l’Orchestratore Tattico ora opera con un mandato aggiornato:

json{

"ticker": "MCORP",

"decisione": "ACQUISTARE (con alta priorità)",

"motivazione": "Convergenza tattica-strategica: notizia valida tendenza quantistica confermata",

"livello_di_confidenza": "Molto Alto",

"quantita": 1500,

"verifica_mandato": {

"rientra_nei_limiti": true,

"motivazione": "Operazione autorizzata da mandato aggiornato post-analisi quantistica"

}

}

Capacità Dimostrate: Fusione analisi tattica (IA classica) e strategica (quantistica), processo decisionale aumentato, esecuzione ad alta convinzione basata su validazione multi-paradigma.

5. Analisi Comparativa delle Performance

StadioTempo RispostaAutonomiaQualità DecisionaleGestione RischioAnalista Aumentato~30 secondi0%BuonaUmanaPartner Proattivo~2 minuti20%Buona+Umana+SistemaAgente Autonomo~45 secondi80%AltaSistematicaQuant-Aumentato~60 secondi85%Molto AltaMulti-paradigma

6. Implicazioni e Discussione

6.1 Convergenza di Paradigmi Computazionali

L’evoluzione documentata dimostra come la convergenza di paradigmi computazionali diversi—percezione contestuale dell’IA classica ed esplorazione profonda degli scenari del calcolo quantistico—possa creare agenti decisionali di potenza senza precedenti. Il Quantum Optimizer non sostituisce l’IA classica, ma la guida fornendo una bussola strategica derivata dall’analisi di complessità superiore.

6.2 Automazione Governata vs Automazione Completa

Il modello proposto dimostra l’efficacia dell’automazione governata rispetto all’automazione completa. Il mantenimento della supervisione umana a livello strategico, combinato con l’autonomia operativa del sistema, crea un equilibrio ottimale tra efficienza e controllo.

6.3 Scalabilità e Robustezza

L’architettura ibrida si dimostra scalabile attraverso la separazione netta tra sistema di indicizzazione (TensorFlow per stabilità) e sistema di generazione (LLM cloud per potenza). Questa separazione garantisce che l’asset di conoscenza vettorializzata rimanga stabile mentre il motore decisionale può evolvere.

7. Limitazioni e Sviluppi Futuri

7.1 Limitazioni Attuali

- Quantum Computing: Le capacità quantistiche simulate richiedono hardware quantistico maturo

- Gap Semantico: Potenziale disallineamento tra modelli di embedding eterogenei

- Complessità Sistemica: Richiede competenze multidisciplinari per deployment

7.2 Sviluppi Futuri

- Integrazione di modelli di sentiment analysis real-time

- Estensione a asset class multiple (crypto, commodities, FX)

- Implementazione di feedback loop per apprendimento continuo

- Sviluppo di stress testing quantistico per scenari estremi

8. Conclusioni

Questo studio documenta l’evoluzione di un Gemello Digitale finanziario attraverso quattro stadi progressivi di autonomia e sofisticazione. L’architettura RAG ibrida proposta dimostra come la combinazione strategica di tecnologie complementari possa superare le limitazioni dei singoli approcci.

Il modello dell’Orchestratore Quant-Aumentato rappresenta un paradigma innovativo dove:

- L’IA Classica eccelle nell’interpretazione del “qui e ora”

- L’Ottimizzazione Quantistica esplora il “e se” di milioni di futuri possibili

- L’Umano definisce la destinazione e le regole del viaggio

Questa convergenza di percezione tattica, profondità strategica e governance umana crea un sistema capace di operare a velocità e con livelli di analisi prima inimmaginabili, mantenendo sempre la supervisione strategica necessaria per la gestione responsabile del rischio finanziario.

Il nostro Gemello Digitale non è più solo un trader; è un sistema che fonde percezione tattica, profondità strategica e governance umana, rappresentando il futuro della finanza aumentata dall’Intelligenza Artificiale.

Questo articolo contribuisce al corpus di ricerca sull’evoluzione dei sistemi AI finanziari e presenta un framework replicabile per lo sviluppo di agenti decisionali autonomi ma governati nel settore finanziario.

RAG (Retrieval-Augmented Generation)

- Paper principale: https://arxiv.org/abs/2005.11401

- Studio Facebook AI: https://ai.facebook.com/blog/retrieval-augmented-generation-streamlining-the-creation-of-intelligent-natural-language-processing-models/

- Survey completo: https://arxiv.org/abs/2312.10997

Quantum Computing in Finance

- IBM Research: https://www.nature.com/articles/s41534-021-00390-4

- Portfolio Optimization: https://arxiv.org/abs/1911.05296

- Quantum Annealing Finance: https://link.springer.com/article/10.1007/s11128-021-03087-1

Digital Twins

- Nature Digital Medicine: https://www.nature.com/articles/s41746-020-0244-4

- IEEE Survey: https://ieeexplore.ieee.org/document/8901113

- MIT Technology Review: https://www.technologyreview.com/2023/03/15/1069823/digital-twins/

Embedding Models & Vector Databases

- Sentence-BERT: https://arxiv.org/abs/1908.10084

- OpenAI Embeddings: https://arxiv.org/abs/2201.10005

- FAISS Facebook: https://arxiv.org/abs/1702.08734

Financial AI & Algorithmic Trading

- Deep Learning Finance: https://www.sciencedirect.com/science/article/pii/S0957417420310344

- AI Portfolio Management: https://www.tandfonline.com/doi/full/10.1080/14697688.2020.1849741

- Automated Trading Systems: https://link.springer.com/article/10.1007/s10479-021-04277-9

Quantum Annealing

- D-Wave Research: https://link.springer.com/article/10.1007/s11128-020-02770-w

- Quantum Optimization: https://arxiv.org/abs/1411.4028

- Finance Applications: https://www.nature.com/articles/s41598-021-99926-x

TensorFlow & MLOps

- TensorFlow Serving: https://arxiv.org/abs/1712.06139

- MLOps Survey: https://arxiv.org/abs/2205.02302

- Production ML: https://proceedings.mlr.press/v97/sculley19a.html

Hybrid AI Architectures

- Neurosymbolic AI: https://www.nature.com/articles/s42256-020-00284-7

- Multi-paradigm Computing: https://dl.acm.org/doi/10.1145/3447772

- Cognitive Architectures: https://link.springer.com/article/10.1007/s10458-021-09515-9